この記事は2023年6月16日に「The Finance」で公開された「AIが抱えるリスクと内部監査において留意すべきポイント ~AIを監査するためのファーストステップ~」を一部編集し、転載したものです。

わが国ではAIの利活用が進み、金融業界でも国際的な原則、規制やガイドラインの整備が急速に進んでいる。しかし、AIのリスクマネジメント面にはいまだ課題があり、内部監査人においても、AIに係るフレームワークや規制の未成熟さ、ガイダンス不足など、AIを監査するに際しての外部環境面での課題がある。本稿ではAI監査を実践するために役に立つ国際的なAI監査フレームワークのガイダンス5選を紹介する。

目次

わが国におけるAI利活用とAIリスク対応の動向

わが国におけるAIの利活用は、PoCから本番運用への移行が進んでいる状況である。業務効率化やコスト削減といった自動化・効率化の観点に加え、マーケティングなどの価値創出の観点でAIを利活用するウエイトが増している。特に金融業界は、AIの利活用が進んでおり、フィンテックという言葉が今や一般化していることからも、金融業がAIの利活用に積極的であることがわかる。海外に目を向けると、特に米系金融機関はAI利活用への投資を積極的に行っており、米キャピタル・ワン・ファイナンシャル、米JPモルガン・チェース、ロイヤル・バンク・オブ・カナダ(RBC)などはトップ3とされている(日本経済新聞調べ/2022年11月11日付)

こうした中、わが国においても、経済産業省「AI原則実践のためのガバナンス・ガイドライン」(2021)や総務省「AI利活用ガイドライン」(2019)が公表されるなど、AIの利活用ルールに係る体制整備が進められている。その一方で、デロイトの調査によれば、AIの利活用におけるリスクマネジメントの観点では、リスクへの認識と対処については、認知は進んできているものの対処までには至っていない傾向が見られるとしている。

AIリスク対応に関する国際的な動向

AIリスクに関する国際的な動向を考える上で、代表的なガイダンスや規制が存在する。

まず、「人口知能に関するOECD原則」(OECD 2019)(*1)はAI原則の代表的なものであり、金融サービス分野では、「金融サービスにおけるAI/ML:市場の発展と金融安定化への影響」(FSB金融安定理事会 2017)(*2)や「AIリスク管理フレームワーク」(NIST米国国立標準技術研究所 2023)(*3)などが国際的なガイダンスとして挙げられる。

また、銀行業界では、BCBS(バーゼル銀行監督委員会)が「人口知能と機会学習に関するニュースレター」 (*4)を公表し、銀行のAI/MLの利活用と監督への潜在的な影響を分析している。議論の中心として、AI/MLモデルの結果の理解と説明、ガバナンス構造の問題、広範な利活用がもたらす潜在的な影響などが挙げられている。証券業界でも、IOSCO(証券監督者国際機構)が「人口知能及び機械学習を利用する市場仲介者及び資産運用会社向けガイダンス」(*5)を公表しており、AI利活用に関する指針を提供している。最近の事例としては、シンガポール金融管理局(*6)主導の金融業界コンソーシアム(*7)が、「金融機関によるAI使用のためのFEAT(*8)原則の評価手法」(*9)をホワイトペーパーとして公表している。

これらのホワイトペーパーやガイダンスの公表といった国際的な動向は、AIリスク対応のためのプリンシプルやフレームワークを提供し、AIの利活用におけるリスクマネジメントの重要性を強調している。今後、国際的イニシアチブとの協力と連携が重要となり、より安全かつ信頼性の高いAI社会の構築に向けて進展していくことが期待される。

※脚注

(*1)OECD Principle on Artificial Intelligence 2019のほか、Advancing accountability AI – Governing and managing risk throughout the lifecycle for trustworthy AI 2023がある

(*2)FSB Artificial intelligence and machine learning in financial services 2017

(*3)NIST Artificial Intelligence Risk Management Framework(AI RMF 1.0) 2023

(*4)BCBS Newsletter on artificial intelligence and machine learning 2022

(*5)IOSCO The use of artificial intelligence and machine learning by market intermediaries and asset managers Final Report 2021

(*6)MAS:Monetary Authority of Singapore

(*7)このコンソーシアムには、アクサ、中国銀行、シンガポール銀行、BNPパリバ、BNYメロン、シティ・シンガポール、DBS銀行、ゴールドマン・サックス、HSBC、中国商工銀行、三菱UFJ銀行、OCBC銀行、プルデンシャル・シンガポール、スタンダード・チャータード銀行、スイス・リー、ユニオンバンク・オブ・フィリピン、ユナイテッド・オーバーシーズ銀行などの主要な金融業界コンソーシアム企業が参加している

(*8)Fairness, Ethics, Accountability, Transparencyの略

(*9)FEAT Principles Assessment Methodology 2022

AIリスクの主な例

そもそもAIにはどのようなリスクが存在するのか整理しておく。AIに関連するリスクは、多岐にわたり数多くのケースが考えられているが、一般的には以下のようなリスクが挙げられている。これらのリスクによる潜在的な影響は、レピュテーションリスク、規制当局の罰金や訴訟といったリスクが内在しているため、現時点ではAI導入を躊躇する企業も少なくない。

- 不適切または典型的でないデータによるバイアスや信頼性の破綻

- 人間の論理エラーがAIテクノロジーに組み込まれる/特定することが難しい人間の先入観がAIテクノロジーに組み込まれる

- AIモデルからのアウトプットの理解不足や説明不足

- データの不適切な使用

- データの入手やAIモデルの操作を目的とした敵対的な攻撃に対する脆弱性

- AIテクノロジーの急速な適用と変革による社会的ストレス

- 同意なしに個人データが使用されることによる影響

- AIシステムによる意思決定や行動に対する法的責任

- AIによる提案に基づく誤った意思決定

- 不十分なAIのテストと監督が倫理的に問題のある結果をもたらす

- AI製品やサービスによる危害が財務上や評判上の損害をもたらす

- 顧客やステークホルダーが組織のAI施策を受け入れない、または採用しない

- AIへの投資が許容水準の投資収益をもたらさない

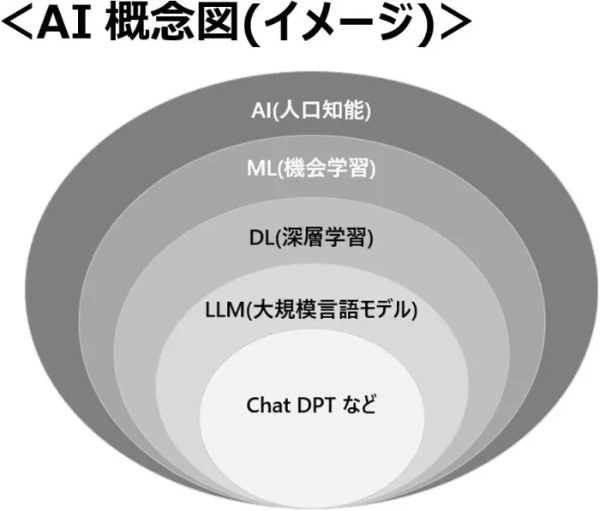

また、例えば、AIとしてのLLM(大規模言語モデル)に代表されるChat GPTなどは、「言葉」で、“どこでも” “誰でも” “簡単に“ 利用できるという汎用性があるため、影響範囲の拡大や顕在化頻度の高まりといったリスクが内在している点に留意する必要がある。

AIについて内部監査人が考慮すべきこと

IIA(内部監査人協会)によれば、AIと内部監査の関係において、内部監査の役割は以下のように述べられている。

『内部監査は組織の目的達成能力に関連するリスクと機会を評価し理解することに熟達している。この経験を活用することで、人工知能が短期、中期、長期の価値を創造する組織の能力に否定的または肯定的な影響を与える程度を評価し、理解し、伝達するのに役立つ。内部監査はAIに関連した少なくとも5つの重要かつ明確な活動を通じて関与することができる。』

① すべての組織の内部監査はリスクアセスメントにAIを含めるべきであり、さらにリスクベースの監査計画にAIを含めるべきか検討すべきである

② AIを検討中の組織の内部監査は、AIプロジェクトの開始から積極的に関与して導入の成功に役立つ助言と洞察を提供すべきである。ただし、AIプロセスや方針や手続の導入について所有したり責任を負ったりすべきではない

③ 何らかの形でAIを業務、または製品やサービスに組み込んでいる組織の内部監査は、根底にあるアルゴリズムとアルゴリズムの基礎となるデータの信頼性に関するリスクの管理についてアシュアランスを提供すべきである

④ 内部監査は、組織のAI使用に関わる道徳的および倫理的な問題の対処をすべきである

⑤ 他の主要なシステムの使用と同様に、適切なガバナンス体制を確立する必要があり、この領域でアシュアランスを提供できるようにすべきである

これらの考慮事項は、内部監査人がAIの導入と利用に伴うリスクを適切に評価し、組織のAI戦略の成功に向けて貢献するために重要である。

AIを監査したい内部監査人の悩み

企業がAIを導入するにつれ、内部監査部門はAIリスクを新たなリスクととらえ、AI監査をテーマ監査として計画することになるであろう。このような状況下において、AIをこれから監査したい、あるいは監査しようと計画している内部監査人が抱える悩みとして、以下のような点が出てくる。

・ AIに特化した内部監査のフレームワークや規制が未成熟である

・ AI活用事例の先行事例が限定的である

・ AIの定義や分類に不明確な点がある

・ AIシステムやAIソリューションに大きな差異がある

・ AIテクノロジーの進化をなかなかキャッチアップしにくい

・ 明示的なAI監査のガイダンスが不十分である

・ AI内部監査人の学習曲線が急である

・ AIを利活用する第三者へのアウトソースが生み出すサードパーティーリスクの存在

これらの悩みは、内部監査人がAIを監査しようとする場面において、恐らく必ず直面するであろう課題であり、解決するためにはAIに関連する規制、AI監査のフレームワークやガイダンスの整備、情報共有の促進といった外部環境、さらにはAIを含むテクノロジーに関する専門知識やスキルの習得(ビッグデータやアルゴリズムに関する知見等)といった内部環境がクリアされることが必要となってくる。

AI監査に役に立つ国際的フレームワーク5選

これまで内部監査の専門家、専門職団体、監督規制当局が多くのコメント、Blog、ホワイトペーパー、ガイダンス等でAIに対する内部監査に関する知見や基本的考え方を公表しているが、(会計監査を含む)内部監査にAIを活用して監査実務の効率化・高度化を目指す動きに比して、まだまだ議論は発展途上といえる。本稿では、現時点において、内部監査人によるAI監査実務に有用と考えられる国際的フレームワークのガイダンス5選を紹介し、その概要を解説する。

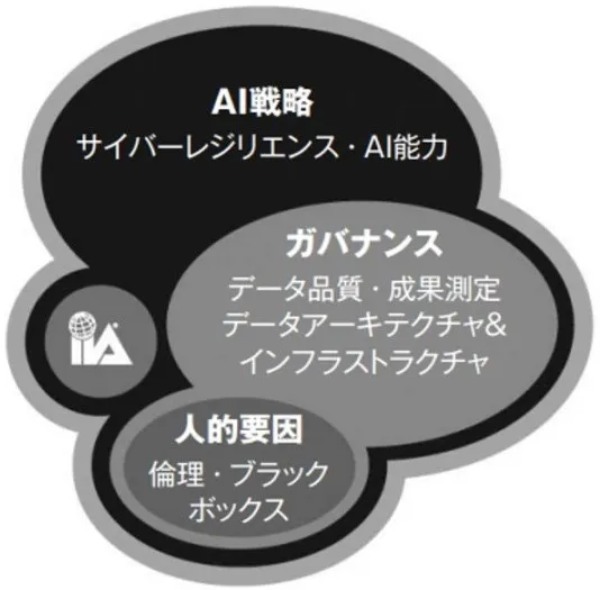

① IIA内部監査人協会「AI監査フレームワーク 2018」(*10)

このフレームワークは、AI戦略、ガバナンス、人的要因の3つの包括的なコンポーネントと、サイバーリジリエンス、AI能力、データ品質、データアーキテクチャとインフラストラクチャ、パフォーマンス測定、倫理、ブラックボックスの7つの要素で構成されている。内部監査機能が「組織がAIの効果の程度を評価、理解、伝達するのを支援する」という役割を果たすことに役に立つ。また、AI監査プログラムを策定する際に活用できる、監査目的(またはコントロール目的)とその監査手続について推奨事項を提供している。

② COSO「ERMフレームワーク 2017」(*11)

このフレームワークは、ガバナンスとカルチャー、戦略と目標設定、パフォーマンス、レビューと修正、情報・伝達および報告、の5つの構成要素と20の原則から構成されており、総合的かつ包括的なリスク管理アプローチを内部監査機能に提供するとともに、リスクマネジメントとAIの戦略およびパフォーマンスを整合させ、AIの可能性を実現させることができるとしている。また、COSO/Deloitte「全社的リスクマネジメント:人口知能の可能性を最大限に実現する~COSOフレームワークと原則を適用した人口知能の導入と拡張の支援~ 2021」(*12)は、AI監査プログラムの策定に有用な考慮すべきポイントを挙げている。

(画像=TheFinance)

③ ISACA情報システムコントロール協会「COBITフレームワーク2019」(*13)

このフレームワークは、企業の情報およびテクノロジーのガバナンスと管理のための包括的フレームワークとして国際的に認知されており、ほぼすべてのIT領域にわたるプロセスの説明、望ましい成果、基本的なプラクティス、および作業成果物が含まれている。このようにITに幅広く適用できることから、内部監査人がAI監査をする際の最初の出発点として適しているとされている。また、ISACA「AI監査 2018」(*14)では、AIを監査する内部監査人が知っておくべきことに焦点を当てており、AIの定義を探り、AIを監査する際の課題を説明し、COBIT2019をAI監査にどのように活用できるかを示している。

(画像=TheFinance)

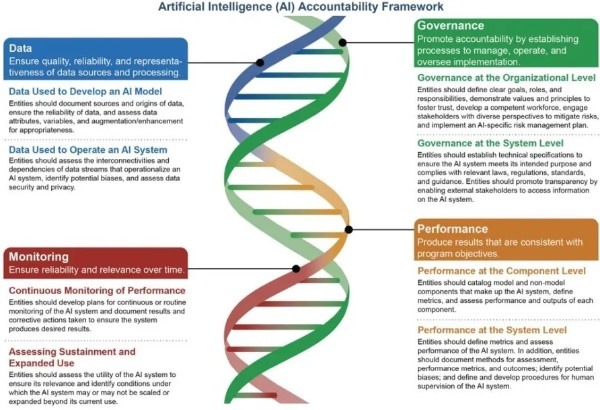

④ GAO米国政府説明責任局「連邦政府及びその他の事業体のためのAI説明責任フレームワーク 2021」(*15)

このフレームワークは、”管理者が政府のプログラムやプロセスにおけるAIの説明責任と責任ある利用を確保できるようにする “ために作成されたものである。このAIフレームワークは、政府のAI利用に対する説明責任に焦点を当てているが、既存の統制基準や政府監査基準に軸足を置いているため、内部監査人は組織のニーズに合わせ、AI監査フレームワークとして活用することができるものとなっている。AIのライフサイクルのあらゆる面で説明責任を果たすための基本条件を定義したこのフレームワークは、ガバナンス、データ、パフォーマンス、モニタリング、の4つの補完的な原則を中心に構成されている。

(画像=TheFinance)

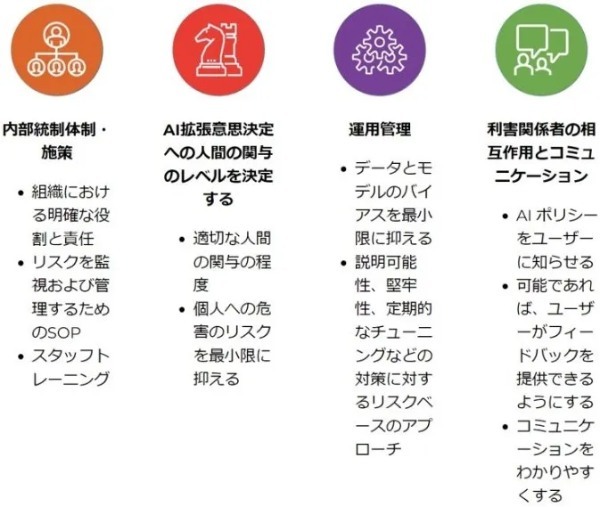

⑤ PDPCシンガポール個人データ保護委員会「モデルAIガバナンスフレームワーク第2版 2020」(*16)

このフレームワークは、シンガポールの個人データ保護委員会(PDPC : Personal Protection Commission of Singapore)が世界経済フォーラムセンター(WEF:World Economic Forum)と共同で作成したものである。内部統制、AI意思決定への人間の関与、運用管理、ステークホルダーとの相互作用とコミュニケーション、の4つの分野に焦点を当てており、組織がAIイニシアチブを展開するにあたって採用すべき考慮事項や対策の基本セットとなっている。AIの内部監査機能を特に意識して作成されたものではないが、このフレームワークと関連する「組織のための実施と自己評価ガイド」(*17)は、組織のAIプログラムを設定したり分析したりする際に、内部監査人に有用な情報を提供するものとなっている。さらに、事例集には、さまざまな分野でフレームワークが実際に使われているケースが示されており、組織が説明可能なAIガバナンスを効果的に導入した具体例も紹介されている。

(画像=TheFinance)

※脚注

(*10)The IIA’s Artificial Intelligence Auditing Framework Practical Applications 2018

(*11)COSO ERM Framework 2017

(*12)Realize the full potential of artificial intelligence – Applying the COSO Framework and Principles to help implement and scale artificial intelligence 2021

(*13)COBIT Framework 2019

(*14)AUDIT AND ASSURANCE:AUDITING ARTIFICIAL INTELLIGENCE 2018

(*15)Artificial Intelligence Accountability Framework for Federal Agencies and Other Entities 2021

(*16)Model Artificial Intelligence Governance Framework 2nd Edition 2020

(*17)ISAGO : Implementation and Self-Assessment Guide for Organizations

まとめ

これらのフレームワークを活用することで、3線の内部監査機能によるAI監査の着眼点とすることができると考える。また、2線のリスク管理機能として、AI特有のリスクを識別して管理し、意図せぬバイアスや透明性の欠如等といったリスクへのエクスポージャーを管理しながら結果を最適化することもできるようになる。

筆者は、上述①IIAと②COSOのフレームワークがわかりやすく平易であるため理解しやすいのでこの2つのフレームワークを参照することを推奨するが、各フレームワークは、必ずしも単独で活用したり、全体を網羅的に活用する必要はなく、それぞれから関連する基本的考え方、着眼点、項目を取り入れて、自社のAI利活用の規模・AI特性・AIリスクプロファイルを踏まえた最適なAI監査フレームワークを構築することが望ましい。

なお、AIはビッグデータとアルゴリズムに依存しているので、AI監査を実施する前に、まずは、組織のビッグデータ戦略を把握し、ビッグデータに係る内部監査を実施し、次に、アルゴリズム監査(バイアス監査と規制検査で構成される)を実施しておくことで、AI監査がより有効かつ実効的になるであろう。ビッグデータ監査については、IIA「ビッグデータの理解と監査 2017」(*18)、アルゴリズム監査については、Ada Lovelace Institute「ブラックボックス検査:アルゴリズムの評価ツール2020」(*19)が有用であるので参照されたい。

※脚注

(*18)Understanding and Auditing Big Data 2017(IIA GTAG)

(*19)Examining the Black Box:Tools for assessing algorithmic systems 2020

【主な参考文献】

・Deloitte AI Institute「AIガバナンスサーベイ AIの実運用とその課題認識における日本企業の概観」(2023年4月)

・COSO/Deloitte「COSOフレームワークと原則を適用した人口知能の導入と拡張の支援」(2021年9月)

・経済産業省「AI原則実践のためのガバナンス・ガイドライン」(2021年7月9日)

・システム監査学会「AI及び個人情報とシステム監査について」(2020年度第34回研究大会 2020年6月)

・ITコーディネーター協会「AIを監査する」(企業内ITC・ITガバナンス研究会 2020年3月)

・日本システム監査人協会「人口知能-内部監査の専門家が考慮すべきこと」(第246回月例研究会 2019年10月)

・総務省「AI利活用ガイドライン」(2019年8月)

・日本内部監査協会「IIAの人口知能監査フレームワーク パートB」(月刊監査研究 2018年4月)

・日本内部監査協会「IIAの人口知能監査フレームワーク パートA」(月刊監査研究 2018年3月)

・日本内部監査協会「人口知能-内部監査の専門家が考慮すべきこと」(月刊監査研究 2018年2月)

・NIST ”Artificial Intelligence Risk Management Framework(AI RMF 1.0)” (2023年1月)

・BIS “Newsletter on artificial intelligence and machine learning” (2022年3月)

・FSB “Artificial intelligence and machine learning in financial services” (2017年11月)

GRCコンサルティング 執行役員ディレクター

大手監査法人、監査法人系コンサルティング会社及び保険会社での勤務経験を有する。金融機関におけるガバナンス、リスクマネジメント、コンプライアンス、内部監査、内部統制、不正防止、金融監督検査行政に精通。30年以上の内部監査実務経験を有する。