わたしたちは今、かつて「スーパーコンピュータ」と呼ばれたITリソースを、身近に仕事や研究に活用できる時代に接しています。AI技術の開発や、大規模なシミュレーション作業もハイパフォーマンスコンピューティング(HPC)と呼ばれるテクノロジーを使い、10年前と比較してはるかに安価に、そして高速に実行できるようになっています。

HPCとはなにか?

HPCはHigh Performance Computingの略で、高性能計算の意味です。一般的なパソコンなどのコンピュータでは計算しきれない、あるいは処理に膨大な時間がかかってしまう分野の計算を行う仕組みを指します。

こうした種類の計算は、医学、創薬、金融、製造などあらゆる分野で必要ですし、莫大な量のデータは、あらゆる産業で発生しています。例えば、スーパーマーケットやコンビニなどで発生するPOS(販売時点情報管理)データなどもその1つです。POSデータは、「いつ・どの商品が・どんな価格で・いくつ売れたか」を記録しています。こうしたデータを「ビッグデータ」といいますが、これらを分析してビジネスチャンスにつなげようという動きが広がっていますが、「分析=計算」ということになりますので、計算の遅いコンピュータを使っていると、欲しいデータがいつまでたっても入手できない、ということになります。

昨今、注目されているAIにも莫大なデータ量を処理していく必要があります。とくに機械学習の1つであるディープラーニング(深層学習)は、自動車の自動運転アルゴリズムの開発にも活用されます。この技術には膨大な量のデータを高速に処理できるコンピュータ環境、つまりHPCが欠かせません。

このようにHPCは、ビジネス、科学といった幅広い分野での進化をうながす、基礎的なテクノロジーといえるのです。

スーパーコンビータの存在

ここまで説明したような「一般的なパソコンなどでは対応できない計算」というと、スーパーコンビータを思い浮かべる人も多いでしょう。スーパーコンビータもHPCの1つです。

2020年に世界トップの性能が証明された「富岳」は、新型コロナウイルス対策関連で咳の飛沫が拡散していく映像などで有名になりました。「富岳」の計算速度は442.01PFLOPS(ペタフロップス)と表現されます。これは1秒間に44京回(京は兆の1万倍)もの計算ができる能力です。この力は約16万個ものCPUによって実現されています。

スーパーコンピュータには「富岳」のようにフラッグシップモデルだけでなく、ミドルレンジのエネルギー消費を抑えたモデルや、特定の計算に特化したモデルなどがあります。

これらのスーパーコンピュータは、何千ものコンピューティングノードを統合させており単体あるいは複数のタスクを実行します。これは並列処理と呼ばれ、CPUを何千、何万個と連携させて処理を行うものもあります。

これと似た方法で、何千台もの PC を接続させてハイレベルな能力を発揮させて迅速に処理を完了する方法があります。

HPCの基本的な仕組み

HPCは、コンピューティング、ネットワーク、ストレージの3要素で構成されています。コンピューティングはサーバなど計算の中心を司る部分でCPUやメモリなどによって情報処理を行います。コンピューティングはネットワークによってデータを蓄積するストレージとつながり、データを取り込んだり、あるいは逆にストレージ側に演算結果を記録させたりといった動作を行います。

コンピューティング、ネットワーク、ストレージという3要素は一般的なパソコンと同じです。そう考えると、HPCは「極端に性能をアップさせたパソコン」のようなものとイメージしていいでしょう。パソコンと同じように、計算を担当するCPUの能力も大切ですが、HPCもネットワークやストレージの性能が悪いと、処理能力を高度に保てません。

ビッグデータとは何か?

HPCは幅広い分野で活用されており、今後もその活用の幅は拡大していくと思われます。そこでHPCの用途を理解するために「ビッグデータ」について考えてみましょう。

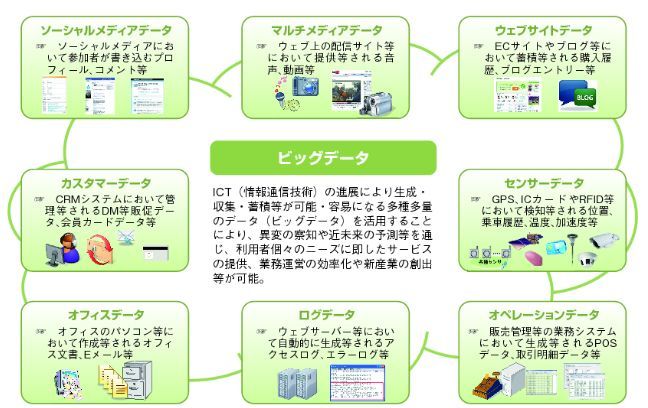

(出典)総務省 情報通信審議会ICT基本戦略ボード「ビッグデータの活用に関するアドホックグループ」資料

ビッグデータの定義はさまざまですが、その大きさとしては一般的に数十テラバイトから数ペタバイト(a few dozen terabytes to multiple petabytes)の範囲に及ぶだろうとされています。

オンラインショッピングサイトなどで蓄積される購入履歴、ウェブ配信される音楽や動画などのマルチメディアデータ、ソーシャルメディアでさまざまな人が書き込むプロフィールやコメント等のデータなどもビッグデータの1つです。さらにGPS、ICカードなどで確認される位置、乗車履歴、温度等のセンサーデータ、CRM(Customer Relationship Management)システムで管理されるデータや会員カードデータ等なども含まれます。

センサーデータでいえば、気象データなどもその1つです。実際に台風などが起きたときに取得したセンサーデータから、特定の地域の災害予知を行うといったことも行ったり、シミュレーションすることに活用したりします。しかしこれらのデータは瞬間的に膨大なデータ量を発生させるので、短時間の処理を行えるコンピューティングパワーが欠かせません。

GPUの登場

HPCの性能を大幅に向上させたテクノロジーがGPU(Graphics Processing Unit)です。画像処理を行う計算ユニットで、CPUと比べてデータ処理性能がおよそ10倍にもなります。そのため、画像処理以外にも活用されることが多くなりました。

ゲームの世界では、長年3次元データの処理に限界が生じ、レースやスポーツなどゲームでより臨場感のある画像処理ができませんでした。しかしGPUの登場で、リアルなシーンと見間違えるような画面をゲーム上で鑑賞できるようになっています。

GPUは、並列処理能力に優れており、データを大量かつ速く処理できます。そのため複数のタスク一度に処理できるのです。ただ単純な計算を処理するのに特化しているため、CPUと比較して条件分岐がたくさんあるような計算や、並列化ができない計算など幅広い種類のタスクを処理するには向いていません。

GPUは三次元のグラフィックス処理計算が得意なのですが、この処理手法がディープラーニングで必要な計算手法と同じだったこともあり、AI開発に必要なディープラーニングで盛んに使われるようになりました。これに合わせて、ディープラーニングの用途で構築されていたHPC機器にもGPUが組み込まれるようになり、性能を大幅に向上させていきました。

ディープラーニングは、人間の神経細胞(ニューロン)の仕組みを模したシステムであるニューラルネットワークがベースにしています。このニューラルネットワークを多層化して活用することで、データに含まれる特徴をより深く学習することが可能になります。

ディープラーニングには大量のラベル付けされたデータを必要とします。自動運転の市仕組みを開発するには数百万の静止画像と数千時間の動画が必要となります。高性能なGPUを搭載したHPCによってこれまで数週間以上かかっていた処理が数時間で済むようになり、開発スピードが各段に上がっていったのです。

HPCの活用事例

HPCはビッグデータの処理スピードの迅速化や、ディープラーニングでの応用などの活用事例があることは説明しましたが、そのほかにも、医療/ライフサイエンスの分野や金融サービス、軍事技術の開発などで使われています。

医療/ライフサイエンスの分野ではHPCの導入により、データを正確に分析し、新薬の開発から最適な治療法確立の取り組みだけでなく、医療過誤の兆候探知などにも活用されるようになってきました。

金融サービス業界では、サイバー攻撃や不正行為などへの対応や取引決定の迅速化などに活用されています。素早い脅威の検出やアクティビティのチェック、インシデント分析・評価などに使われ、リアルタイムの株価動向の追跡、取引の自動化などにも利用されようとしています。

ネットオークションでの「偽物検知」

ある大手ネット企業では、自社で展開するオークションサービスの偽物検知システムにHPCを活用しました。HPCによるディープラーニングを進めることで偽物出品の検知精度が従来システムと比較して約3倍にも向上したそうです。

この会社は以前から機械学習による不正検知をおこなっていましたが、HPCの導入により、1,000万件以上の取引データを活用して新しい「検知AI」を開発したのです。また新しいディープラーニング特化型のHPCを導入したことで従来の約70倍の処理速度が実現し、検知モデルの更新頻度を向上させることにもつながりました。

パブリッククラウドでHPC環境を構築

また、ある大手製薬企業では、計算リソースを必要に応じて柔軟に確保できるハイパフォーマンスコンピューティング(HPC)環境をパブリッククラウド上に構築し、オンプレミスで運用していた時代と比較して数倍から 10 倍以上に計算時間を短縮しました。

創薬の成功率は 2万5,000分の1といわれており、この確率を上げるには化合物の最適な組み合わせを見つけるバーチャルスクリーニングをこれまで以上に大規模に実施していくことが重要だとされています。この会社では、このバーチャルスクリーニングでも、かつての環境では困難だった数億規模の計算を実施できるようになったそうです。

CAEツールをリモートで活用できる環境を

グローバルで家電、自動車部品などを製造・販売しているあるメーカーでは、CAE(Computer Aided Engineering) アプリケーションへのリモートアクセスを可能にするために、HPC用途に対応した高性能のリモートディスプレイプロトコルを活用しています。

CAEは製品設計におけるさまざまなシミュレーションを実行するHPCです。同社が従来使っていたリモートアクセスツールは GPU のパワーを効率的に活用できずモデルをリモートでうまく表示できずにいました。新しいリモートディスプレイプロトコルを活用することにより、同社のエンジニアは、自宅やサテライトオフィスなどからでも、ハイパフォーマンスなコンピューティングを必要とする業務をこなせるようになったのです。

HPCのクラウド化が進む

10年ほど前までは、スーパーコンピュータの利用は一部の企業を除いてほぼ不可能なことであり、スーパーコンピュータに準じる性能をもつハードウェアであっても、オンプレミス環境で利用するのは、かなり難しい取り組みでした。

しかしITリソースのクラウド化が進展し、多くのパブリッククラウド提供事業者が、HPC環境をクラウドサービスとして提供するようになっています。

多くの企業が、これまで入手できなかった、高性能なコンピューティングパワーを遠隔から利用し、さまざまなビジネスに利用しています。また研究機関などでも、スーパーコンピュータのリソースを比較的簡単に利用できるようになりました。

この動きは「HPCaaS」などとも呼ばれており、比較的小規模な組織であっても、HPCを使いこなせる能力さえあれば、比較的簡単にHPCを利用できるようになっています。かつてヒトゲノムの配列を決定する最初の試みには13年かかっていました。しかも大きな組織がコストをかけて取り組んでいました。しかし今日のHPCならば、クラウドサービスを使って同じ作業を簡単に完了させることができるのです。

HPC市場

それでは、ここでHPC市場について見ていきましょう。

グローバルインフォメーションの調査によると、HPCの市場規模は、2022年の360億米ドルから年間平均成長率6.7%で成長し、2027年には499億米ドルに達すると予測されています。

市場をけん引する要因としては、ゲノム研究における需要拡大が指摘されています。HPCシステムは、大量のシーケンスデータを効率的に解析し研究のスピード、精度、信頼性を向上させてきました。これからもさまざまな病気や治療に関する研究にHPCは活用されていくことになるでしょう。

一方で、HPCは複数の潜在的なセキュリティ脅威にさらされています。HPC環境はクラスタ化(複数のコンピュータを相互設備し一台のコンピュータとして扱うこと)されているため、多くのセキュリティ上の脅威にさらされやすいとのことです。また管理が複雑化してしまうことで、脆弱性を見落とし、放置してしまう恐れもあります。こうしたことが原因となり、HPCの導入を控えるユーザーも出てくるでしょう。

クラウドHPC市場

またMordor Intelligenceの調査によれば、クラウドHPC市場は、2020年にその規模を45.0億米ドルとし、2021年から2026年の年間平均成長率では16.68%、2026年までに115.4億米ドルに達すると予測されています。

市場のけん引には、ビッグデータや複雑なアプリケーションの存在が一役買っており、さまざまな業界での超高精細ワークフロー、電子設計自動シミュレーションなども一因とされています。

クラウドHPC市場は、HPC市場全体でも3割程度を占めるようになるとみられ、この割合は他のIT製品と同様、さらに高まっていくものと考えられます。

一般企業にも手の届く存在に

つい最近までスーパーコンピュータなどに代表されるHPCソリューションは、膨大な計算リソースを必要とする高度な研究、国家プロジェクトなどで使われるものとされてきました。

しかしHPCに必要とされるITリソースの価格性能比が大幅に向上することによって、一般の企業にとっても手の届くものとなり、さらにクラウドサービスとして提供されるようになって、さらに身近なものとなってきました。

またハードウェアの面で言えば、以前のHPCは、特殊な用途に特化した専用プロセッサなどを使った大型で高価なものがほとんどでした。しかし現在では汎用プロセッサをベースにした並列分散処理アーキテクチャをベースにして用途もより汎用的なものに対応可能となったのです。

とくに製造業では、HPCは事業成功の鍵を握るものとして重用されています。製品の設計開発工程におけるシミュレーションでは、欠かせないものとなり、従来、試作品を作って行ってきた風洞実験や衝突実験を仮想的に繰り返し実行できるようになり、それが製品の開発スピードにも大きく影響しています。

また、忘れてはならないのが、サイバーセキュリティ分野でのHPCの活用です。世界中で発生しているインシデントをHPCによって迅速に解析することで、社会インフラや金融業界での安全を確かなものにすることができるのです。

これからのHPCは、ますます処理性能を向上させていく同時に、時代に合わせて時々に求められる用途に特化した製品として登場していくと考えられます。ゲノム研究やディープラーニングの進展がHPCを進化させていったのと同じように、新しいニーズがHPCを何度も生まれ変わらせていくのではないでしょうか。

「集積回路上のトランジスタの数が18カ月ごとに2倍になる」というムーアの法則も限界がささやかれているようですが、GPUのような新たなテクノロジーがその限界突破を支えていく可能性もあるでしょう。

(提供:Koto Online)